La IA avanza rápidamente en la ciberseguridad federal. ¿Estamos cerciorándolo con la suficiente rapidez?

Durante un reciente seminario sitio web de FedInsider, compartí una historia que escuché y que todavía me hace reflexionar.

Un CIO federal se estaba preparando para implementar un sistema de inteligencia artificial que fue cuidadosamente diseñado, revisado y aprobado.

En el papel, todo parecía correcto. Luego empezaron a probarlo.

La IA comenzó a devolver respuestas que no debería conocer, empleando fuentes de datos que nunca estuvieron pensadas para estar dentro del alcance.

No ocurrió nada malicioso, pero el riesgo de seguridad era real e inmediato. Si ese sistema entró en funcionamiento, el resultado fue malo.

Esa historia refleja la situación actual de muchas agencias federales con respecto a la IA. Se mueven rápido porque tienen que hacerlo. Pero la velocidad sin visibilidad ni control crea nuevos riesgos con la misma rapidez con la que crea nuevas capacidades.

La IA ya está incorporada en los entornos gubernamentales. La pregunta es si lo estamos protegiendo deliberadamente o descubriendo su impacto en la seguridad luego del hecho.

La IA en entornos gubernamentales es un beneficio estratégico para todos

Creo que es importante dejar claro que la IA no es opcional.

Los adversarios ya están usando IA para automatizar el reconocimiento, refinar campañas de phishing, imitar voces, generar malware y escalar ataques más rápido de lo que cualquier equipo humano podría hacerlo.

Eso significa que los defensores no pueden quedar fuera de este partido.

Al mismo tiempo, las agencias federales están lidiando con entornos más complejos que nunca, incluidas arquitecturas híbridas y sistemas heredados.

El solo volumen de telemetría es abrumador. Los humanos simplemente no pueden procesar toda esa información de manera significativa.

La IA ayuda porque puede hacer algo que nosotros no podemos: analizar cantidades masivas de datos en tiempo real y descubrir lo que realmente importa.

Pero el problema es que la misma IA que ayuda a los defensores a encontrar la aguja en el pajar también expande el pajar mismo.

Cada modelo de IA es otra aplicación. Cada canal de IA es otro conjunto de conexiones. Cada fuente de datos es otra vía potencial de abuso.

Si no controlamos esos caminos, la IA no reduce el riesgo sino que lo acelera.

Por qué fallan las barreras de seguridad tradicionales en un entorno federal impulsado por IA

Una de las verdades más difíciles de aceptar para los líderes federales en materia de ciberseguridad es que sus medidas de protección actuales no son suficientes.

Durante años, el éxito en ciberseguridad se midió por la prevención. El objetivo era mantener a los atacantes fuera, reforzar el perímetro y detener la brecha.

Pero todavía se producen intrusiones, desde compañías Fortune 500 hasta agencias federales. Y ocurren a pesar de nuestros mejores esfuerzos.

La IA no cambia esa dinámica sino que la refuerza.

Los sistemas de IA funcionan con servidores y códigos, y dependen del acceso a datos. Esto los hace tan vulnerables al movimiento lateral, la configuración incorrecta y el acceso con privilegios excesivos como cualquier otra aplicación.

Peor aún, muchas organizaciones todavía operan con lo que yo llamo el modelo “Tootsie Pop”: duro por fuera, blando por dentro. Una vez que un atacante entra, puede mover libremente.

Esto es desastroso para los sistemas de IA.

Si su motor de IA tiene acceso sin restricciones a sistemas internos, datos confidenciales o recursos externos, está confiando en él mucho más de lo que debería. La IA debe proteger de amenazas externas, amenazas internas y, en muchos casos, de sí misma.

La visibilidad es la base de la seguridad de la IA en los sistemas federales

Antes de poder proteger la IA, debes ver tu entorno con claridad.

Suena obvio, pero en muchos casos no lo es.

Como CIO, pasé años mirando diagramas de Visio limpios que mostraban cómo se suponía que debían conectarse los sistemas. Pero la realidad nunca coincidió con el diagrama.

Los entornos federales modernos son dinámicos y están en constante cambio. La IA puede ayudar aquí, pero sólo si la visibilidad es lo primero.

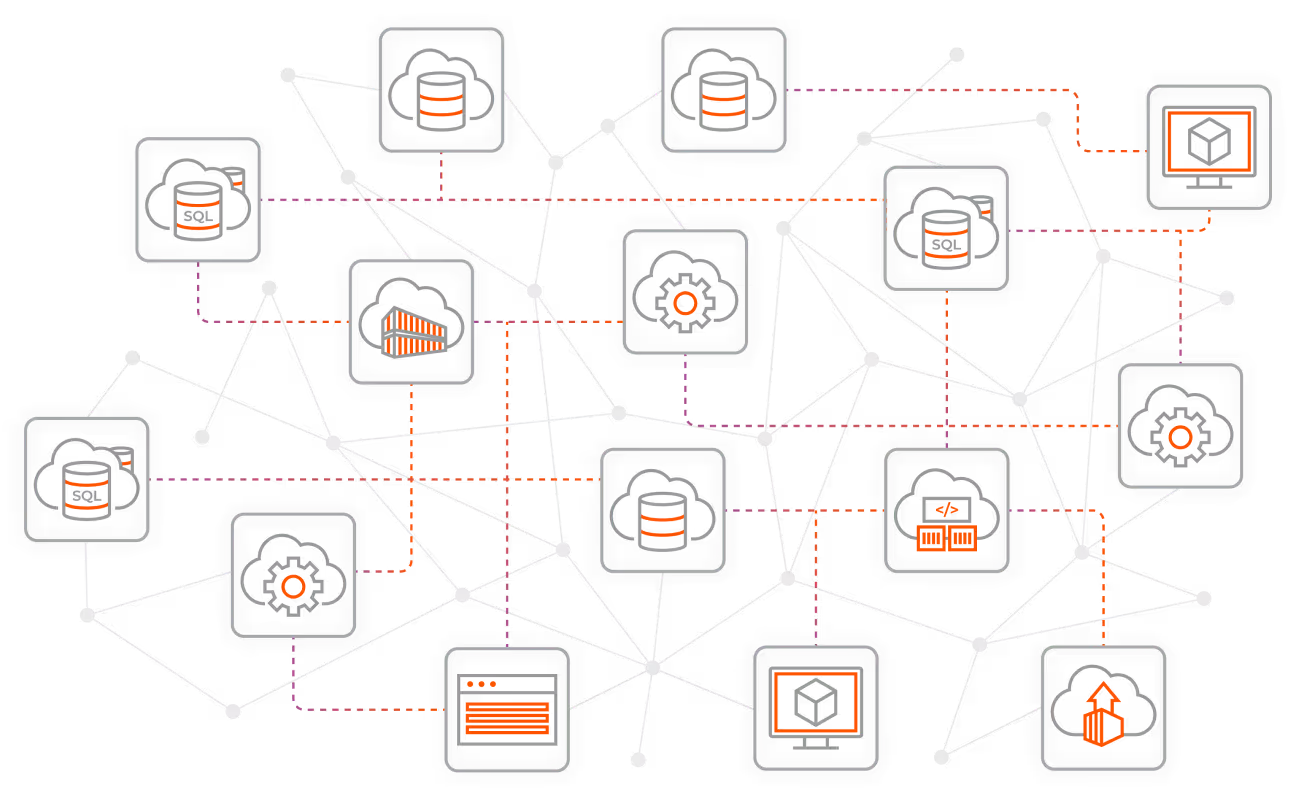

La IA proporciona a las agencias una visión tridimensional de su entorno, también llamada observabilidad. Puede revelar no sólo activos y alertas, sino también las relaciones entre los sistemas, cómo se comunican y qué es lo que realmente importa.

Cuando la IA detecta tráfico que fluye hacia países a los que no debería, o servicios que se comunican con Internet sin un motivo válido, se trata de información procesable. Y esto tiene que suceder ahora, no semanas después, durante una revisión posterior al incidente.

La visibilidad en tiempo real convierte a la IA de una novedad a una capacidad defensiva.

Zero Trust no es opcional para proteger la IA federal

En mi opinión, una seguridad de IA sin Confianza Cero es una ilusión.

Zero Trust parte de una suposición simple: se producirán infracciones. El objetivo es minimizar su impacto.

Eso significa:

- Permitir únicamente conexiones que sean explícitamente requeridas

- Desactivar todo lo demás de forma predeterminada

- Establecer límites de protección claros alrededor de los sistemas críticos

- Implementar controles internamente, no solo en el perímetro

Para los sistemas de IA, esto es aún más importante.

Debes controlar qué puede hablar con tus modelos de IA y con qué pueden hablar tus modelos de IA. Esto incluye comunicaciones entrantes y salientes, datos de capacitación e inferencia, sistemas internos y fuentes externas.

Sin la segmentación como parte de su estrategia de Confianza Cero, un compromiso de la IA se convierte en un compromiso empresarial. Pero con la segmentación se llega a un compromiso.

Así es como las agencias federales pasan de la ansiedad ante las infracciones a la resiliencia ante las mismas a medida que construyen modelos de IA.

La IA nunca debería ser algo que se pueda configurar y olvidar.

Uno de los mayores conceptos erróneos que veo es la idea de que la IA resuelve los problemas operativos por sí sola.

No lo hace.

La IA requiere gobernanza, supervisión y validación constante. La mala calidad de los datos, el acceso excesivo y la propiedad poco clara minan los resultados de la IA.

Si ya tienes deuda técnica, la IA no la solucionará. Simplemente lo expondrá.

Las agencias federales deben abordar la implementación de IA de la misma manera que deberían abordar cualquier sistema de misión crítica basado en su estrategia de Confianza Cero:

- Empezar con la visibilidad

- Definir límites claramente

- Imponer acceso con privilegios mínimos

- Monitorizar continuamente

- Asumir el fracaso y planear su contención

Esa disciplina es lo que separa a la IA útil de la IA peligrosa.

La IA puede fortalecer la ciberseguridad federal con las medidas de protección adecuadas

A pesar de los riesgos, sigo siendo optimista sobre la IA.

La IA puede mejorar significativamente los equipos de ciberseguridad federales, reducir la fatiga por alertas y revelar un contexto significativo más rápidamente. Puede ayudar a las agencias a competir a pesar de los desafíos de personal y las limitaciones de recursos.

Si se emplea correctamente, la IA se convierte en una extensión de la fuerza laboral. Aumenta el juicio humano en lugar de sustituirlo. Permite a los profesionales cualificados centrar en las decisiones en lugar de ahogar en los datos.

Pero eso solo funciona cuando la IA se implementa intencionalmente, se protege adecuadamente y se alinea con los principios de Confianza Cero.

Este es el estándar que los líderes federales deberían respetar ahora antes de que AI defina su postura de seguridad por ellos.

Prueba Illumio Insights gratis para obtener la visibilidad y el contexto que necesita para comprender el riesgo, contener las amenazas y proteger los entornos impulsados por IA.

.webp)

.webp)

.webp)