L'IA progresse rapidement dans le domaine de la cybersécurité au niveau fédéral. La sécurisation est-elle assez rapide ?

Lors d'un récent webinaire de FedInsider, j'ai raconté une histoire que j'ai entendue et qui me fait encore réfléchir.

Un DSI fédéral s'apprêtait à déployer un système d'IA qui avait été soigneusement évalué, examiné et approuvé.

Sur le papier, tout semblait parfait. Ils ont ensuite commencé à le tester.

L'IA a commencé à renvoyer des réponses qu'elle n'aurait pas dû connaître, en utilisant des sources de données qui n'ont jamais été censées être dans le champ d'application.

Rien de malveillant ne s'était produit, mais le risque pour la sécurité était réel et immédiat. Si ce système avait été mis en service, le résultat aurait été mauvais.

Cette histoire montre bien où en sont aujourd'hui de nombreuses agences fédérales en matière d'IA. Ils avancent rapidement parce qu'ils doivent le faire. Mais la rapidité sans visibilité ni contrôle crée de nouveaux risques aussi rapidement qu'elle crée de nouvelles capacités.

L'IA est déjà intégrée dans les environnements gouvernementaux. La question est de savoir si nous le sécurisons délibérément ou si nous découvrons son impact sur la sécurité après coup.

L'IA dans les environnements gouvernementaux est un avantage stratégique pour tout le monde

Je pense qu'il est important de préciser que l'IA n'est pas facultative.

Les adversaires utilisent déjà l'IA pour automatiser la reconnaissance, affiner les campagnes de phishing, imiter les voix, générer des logiciels malveillants et étendre les attaques plus rapidement qu'une équipe humaine ne pourrait jamais le faire.

Cela signifie que les défenseurs n'ont pas l'occasion de s'asseoir.

Dans le même temps, les agences fédérales sont confrontées à des environnements plus complexes que jamais, notamment des architectures hybrides et des systèmes hérités.

Le volume de télémétrie est à lui seul écrasant. Les humains ne peuvent tout simplement pas traiter toutes ces informations de manière significative.

L'IA est utile parce qu'elle peut faire quelque chose que nous ne pouvons pas faire : analyser des quantités massives de données en temps réel et faire ressortir ce qui est réellement important.

Mais le problème est que l'IA qui aide les défenseurs à trouver l'aiguille dans la botte de foin élargit également la botte de foin elle-même.

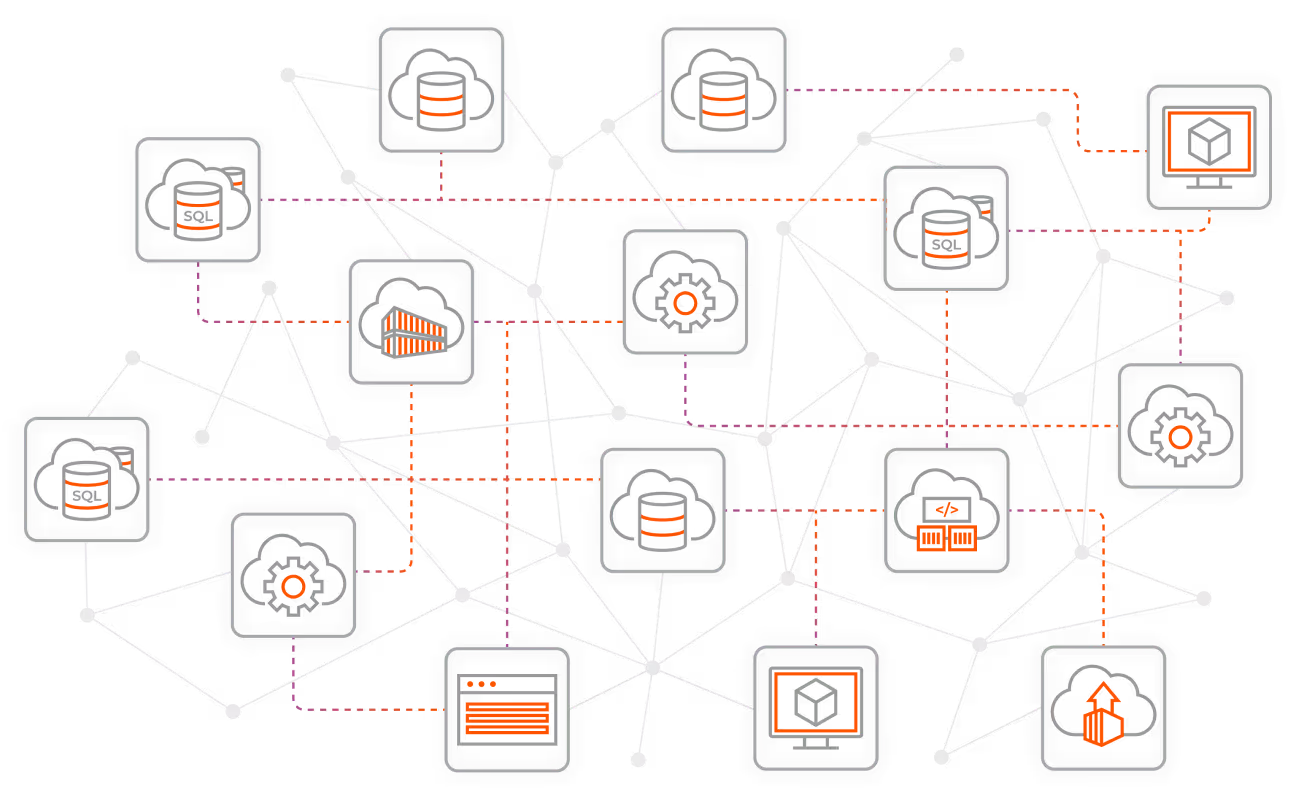

Chaque modèle d'IA est une nouvelle application. Chaque filière d'IA est un nouvel ensemble de connexions. Chaque source de données est une autre voie potentielle d'abus.

Si vous ne contrôlez pas ces voies, l'IA ne réduit pas le risque mais l'accélère.

Pourquoi les garde-fous traditionnels échouent dans un environnement fédéral piloté par l'IA ?

L'une des vérités les plus difficiles à accepter pour les responsables fédéraux de la cybersécurité est que leurs garde-fous actuels ne sont pas suffisants.

Pendant des années, la réussite en matière de cybersécurité s'est mesurée à l'aune de la prévention. L'objectif était d'empêcher les attaquants d'entrer, de renforcer le périmètre et d'arrêter l'intrusion.

Mais les intrusions se poursuivent, qu'il s'agisse d'entreprises du Fortune 500 ou d'agences fédérales. Et ils se produisent malgré tous nos efforts.

L'IA ne modifie pas cette dynamique, mais la renforce.

Les systèmes d'IA fonctionnent sur des serveurs et des codes, et ils dépendent de l'accès aux données. Cela les rend tout aussi vulnérables aux mouvements latéraux, aux erreurs de configuration et aux accès privilégiés que n'importe quelle autre application.

Pire encore, de nombreuses organisations fonctionnent encore selon ce que j'appelle le modèle "Tootsie Pop" : dur à l'extérieur, mou à l'intérieur. Une fois qu'un attaquant est entré, il peut se déplacer librement.

C'est désastreux pour les systèmes d'intelligence artificielle.

Si votre moteur d'IA a un accès illimité aux systèmes internes, aux données sensibles ou aux ressources externes, vous lui faites beaucoup plus confiance que vous ne le devriez. L'IA doit être protégée des menaces externes, des menaces internes et, dans de nombreux cas, d'elle-même.

La visibilité est le fondement de la sécurité de l'IA dans les systèmes fédéraux

Avant de pouvoir sécuriser l'IA, vous devez avoir une vision claire de votre environnement.

Cela semble évident, mais dans de nombreux cas, ce n'est pas le cas.

En tant que DSI, j'ai passé des années à regarder des diagrammes Visio propres qui montraient comment les systèmes étaient censés être connectés. Mais la réalité n'a jamais correspondu au schéma.

Les environnements fédéraux modernes sont dynamiques et en constante évolution. L'IA peut être utile à cet égard, mais seulement si la visibilité est prioritaire.

L'IA donne aux agences une vue tridimensionnelle de leur environnement, également appelée observabilité. Il peut révéler non seulement les actifs et les alertes, mais aussi les relations entre les systèmes, la manière dont ils communiquent et ce qui est réellement important.

Lorsque l'IA met en évidence un trafic qui se dirige vers des pays où il ne devrait pas se trouver, ou des services qui communiquent avec l'internet sans raison valable, il s'agit là d'une information exploitable. Et cela doit se faire maintenant, pas des semaines plus tard lors d'un examen post-incident.

Grâce à la visibilité en temps réel, l'IA n'est plus une nouveauté, mais une capacité défensive.

La confiance zéro n'est pas facultative pour sécuriser l'IA fédérale

À mon avis, la sécurité de l'IA sans la confiance zéro est un vœu pieux.

La confiance zéro part d'une hypothèse simple : des violations se produiront. L'objectif est de minimiser leur impact.

En d'autres termes :

- N'autoriser que les connexions explicitement requises

- Désactiver tout le reste par défaut

- Établir des limites de protection claires autour des systèmes critiques

- Renforcer les contrôles au niveau interne, et pas seulement au niveau du périmètre

Pour les systèmes d'intelligence artificielle, l'enjeu est encore plus important.

Vous devez contrôler ce qui peut parler à vos modèles d'IA et ce à quoi vos modèles d'IA peuvent parler. Cela comprend les communications entrantes et sortantes, les données de formation et d'inférence, les systèmes internes et les sources externes.

Sans segmentation dans le cadre de votre stratégie de confiance zéro, une compromission de l'IA devient une compromission de l'entreprise. Mais avec la segmentation, un compromis est possible.

Voici comment les agences fédérales passent de l'inquiétude à la résilience en construisant des modèles d'IA.

L'IA ne devrait jamais être "prête à l'emploi et oubliée"

L'une des plus grandes idées fausses que je vois est l'idée que l'IA résout les problèmes opérationnels par elle-même.

Ce n'est pas le cas.

L'IA nécessite une gouvernance, une supervision et une validation constante. La mauvaise qualité des données, l'accès excessif et le manque de clarté quant à leur propriété sont autant de facteurs qui nuisent aux résultats de l'IA.

Si vous avez déjà une dette technique, l'IA n'y remédiera pas. Cela ne fera que l'exposer.

Les agences fédérales doivent aborder le déploiement de l'IA de la même manière qu'elles devraient aborder tout système critique, en se basant sur leur stratégie de confiance zéro :

- Commencez par la visibilité

- Définir clairement les limites

- Appliquer l'accès au moindre privilège

- Contrôler en permanence

- Supposer un échec et planifier le confinement

Cette discipline est ce qui distingue l'IA utile de l'IA dangereuse.

L'IA peut renforcer la cybersécurité au niveau fédéral avec les bons garde-fous

Malgré les risques, je reste optimiste quant à l'IA.

L'IA peut considérablement renforcer les équipes fédérales chargées de la cybersécurité, réduire la fatigue liée aux alertes et mettre en évidence plus rapidement un contexte significatif. Il peut aider les agences à être compétitives malgré les problèmes de personnel et les contraintes de ressources.

Utilisée correctement, l'IA devient une extension du personnel. Il complète le jugement humain au lieu de le remplacer. Il permet aux professionnels qualifiés de se concentrer sur les décisions au lieu de se noyer dans les données.

Mais cela ne fonctionne que si l'IA est déployée de manière intentionnelle, correctement sécurisée et alignée sur les principes de la confiance zéro.

C'est la norme à laquelle les dirigeants fédéraux doivent se conformer avant que l'IA ne définisse leur posture de sécurité à leur place.

Essayez Illumio Insights gratuitement pour obtenir la visibilité et le contexte dont vous avez besoin pour comprendre les risques, contenir les menaces et sécuriser les environnements pilotés par l'IA.

.webp)

.webp)

.webp)